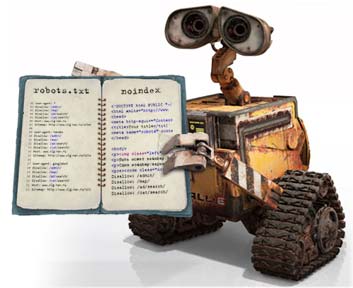

Você que tem um blog , site, seja o que for na internet é hora de começar a pensar muito bem sobre um arquivo muito esquecido pela maioria das pessoas.

De acordo com Eric Kuan do Google o buscador agora tende a interromper a indexação de um site caso não consiga encontrar ou verificar corretamente o conteúdo do arquivo Robots.txt que sim, tem que estar na raiz de qualquer site publicado na internet

Se o Google tem dificuldades em rastrear o arquivo robots.txt, ele vai parar de indexar o resto do seu site para evitar que ele indexe páginas que foram bloqueadas pelo arquivo. Se isso não está acontecendo com freqüência, então provavelmente é um problema que você não vai precisar se preocupar. Se isso está acontecendo com freqüência ou se você está preocupado, você deve considerar contatar seu provedor de hospedagem ou serviço para ver se eles verifiquem quaisquer questões caso ocorra algum erro de rastreamento, disse.

Não que o arquivo seja obrigatório, porque ele não é, mas agora você sabe que de uma hora para outra você vai parar de aparecer nas buscas do Google, o que é péssimo.

Assim, tome o cuidado de criar um arquivo robots.txt, há diversos materiais na internet e, caso tenha alguma dúvida, deixe seu comentário aí que dentro do possível tentarei lhe ajudar :-)

Via: Google Discovery